我院多名本科生研究成果被国际顶级会议接收

一、我院本科生研究成果被多媒体与人工智能领域的国际顶级会议ACM MM 2025接收

近日,人工智能学院2021级本科生叶志宇以第一作者身份与团队合作完成的研究成果《Quantifying Samples with Invariance for Source-Free Class Incremental Domain Adaptation》(通讯作者为郑珏鹏助理教授)和2022级本科生孟怡然、叶俊宏以共同第一作者身份合作完成的研究成果《VideoForest:Person-Anchored Hierarchical Reasoning for Cross-Video Question Answering》(通讯作者为赵宝全副教授)成功入选国际顶级学术会议ACM Multimedia 2025(ACMMM 2025)。ACM Multimedia(ACMMM)是多媒体与人工智能交叉领域的国际顶级会议,也是中国计算机学会推荐的CCF A类会议,聚焦计算机视觉、自然语言处理、音视频理解、多模态学习、生成式AI等前沿方向,代表着该领域的最高学术水平。

图1 《Quantifying Samples with Invariance for Source-Free Class Incremental Domain Adaptation》的研究架构

《Quantifying Samples with Invariance for Source-Free Class Incremental Domain Adaptation》工作聚焦现实场景中愈发常见的源数据不可访问、目标环境不断变化、类别持续扩展的学习问题,提出了一种新颖的不变性量化机制,以实现更稳定、更泛化的跨域增量学习。

该研究围绕“源数据不可访问的类增量式跨域适应(Source-Free Class Incremental Domain Adaptation)”任务,系统解决了模型在持续适应新类别与新域时面临的灾难性遗忘与领域偏移问题。团队提出的样本衡量方法,能有效筛选出具有代表性和学习价值的样本,并构建动态更新机制与记忆优化策略,使模型在不依赖源数据的前提下实现稳健进化,显著提升了模型的泛化能力。

图2 VideoForest的研究架构

《VideoForest:Person-Anchored Hierarchical Reasoning for Cross-Video Question Answering》聚焦跨视频问答面临的关键挑战,特别是在构建跨视频语义关联与多源信息高效管理方面的难题。

团队提出了全新框架 VideoForest,以人物为中心构建多粒度语义树结构,并结合大模型和多智能体协同推理机制,在无需端到端训练的前提下实现高效、泛化的跨视频理解。为评估方法效果,研究构建了以人物中心的跨视频问答基准数据集 CrossVideoQA,实验结果显示 VideoForest 在多个核心指标上显著优于现有方法,展现了其在跨视频语义信息分析与推理任务中的广阔前景。

二、我院本科生研究成果被人机交互领域的国际顶级会议ACM CSCW 2025接收

近日,人工智能学院2021级本科生陈霞、陈心悦、胡玮锨、郑浩佳和钱俞均合作完成的研究成果《Redesign of Online Design Communities: Facilitating Personalized Visual Design Learning with Structured Comments》和2022级本科生潘琦宇、曾健桥、王洁、刘俊宇、裘一涵和2020级本科生袁康宇合作完成的研究成果《AMQuestioner: Training Critical Thinking with Question-Driven Interactive Argument Maps in Online Discussion》(通讯作者均为彭振辉副教授)成功入选国际顶级学术会议ACM SIGCHI Conference on Computer-Supported Cooperative Work & Social Computing 2025 (CSCW 2025) 。ACM CSCW 是人机交互与社会计算领域的国际顶级会议,也是中国计算机学会推荐的CCF A类会议,聚焦影响群体、组织、社区和网络的技术设计和使用研究。

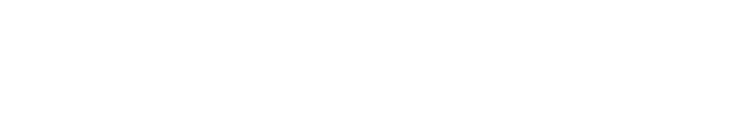

图1 《Redesign of Online Design Communities: Facilitating Personalized Visual Design Learning with Structured Comments》DesignLearner交互界面

《Redesign of Online Design Communities: Facilitating Personalized Visual Design Learning with Structured Comments》聚焦初学者浏览在线社区学习设计类知识时的帖子筛选、评论阅读和知识整理挑战,首先构建了基于UI 组件(例如按钮、文本)和视觉元素(例如颜色、对比度)的评论分类数据集,接着提出了在线社区“学习者”模式交互界面DesignLearner,帮助用户筛选、阅读和整理包含他们感兴趣的知识点的帖子和评论。用户实验表明,与传统的 社区界面相比,DesignLearner可以显著提升用户的在线社区学习效果和体验。

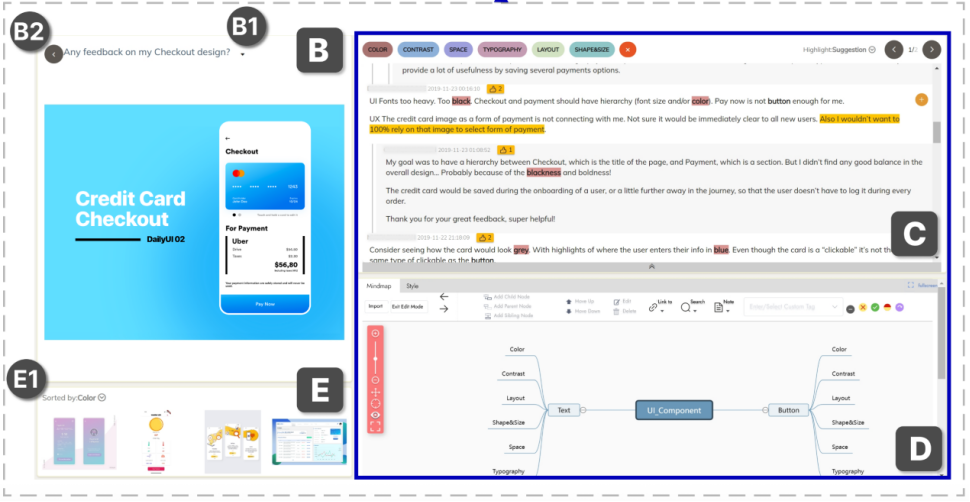

图2《AMQuestioner: Training Critical Thinking with Question-Driven Interactive Argument Maps in Online Discussion》AMQuestioner交互界面

《AMQuestioner: Training Critical Thinking with Question-Driven Interactive Argument Maps in Online Discussion》旨在培养用户浏览社交媒体时的批判性思维,创新性地提出“论证图”+“对话机器人”的边看边学习的批判性思维训练工具AMQuestioner。AMQuestioner首先挖掘用户浏览的帖子及其评论中的论点论据及其关系生成论证图,然后通过聊天机器人提出苏格拉底式问题,引导用户探索论证图中他人的论点和进行批判性思维练习。用户实验表明,与没有聊天机器人的基准工具相比,经过 AMQuestioner 训练的用户在独立进行详细、具体且与主题相关的论证方面表现出显著的进步,也表现出更强的开放心态来接受他人的论点。